باحثو جامعة شيكاغو يسعون لـ “تسميم” مُنشئي الذكاء الاصطناعي باستخدام “نايتشايد” Nightshade

الصور المعدلة قد تُدمر جهود تدريب النماذج الذكية للذكاء الاصطناعي التي تقوم بجمع الأعمال الفنية بدون إذن

في يوم الجمعة، قام فريق من الباحثين في جامعة شيكاغو بنشر ورقة بحثية تستعرض تقنية “نايتشايد”، وهي تقنية تسميم البيانات تهدف إلى تعطيل عملية تدريب النماذج الذكية، وذلك حسب تقارير MIT Technology Review وVentureBeat.

الهدف من هذه التقنية هو مساعدة الفنانين البصريين والناشرين على حماية أعمالهم من استخدامها في تدريب نماذج الذكاء الاصطناعي التي تولد صورًا فنية، مثل Midjourney وDALL-E 3 وStable Diffusion.

الصور المعدلة قد تُدمر جهود تدريب النماذج الذكية للذكاء الاصطناعي التي تقوم بجمع الأعمال الفنية بدون إذن

تقوم هذه التقنية، التي يُشير إليها بأنها “حبة السم” مصدرها جامعة شيكاغو، بتعديل الصور بطرق لا يمكن رؤيتها بالعين المجردة والتي يمكن أن تؤدي إلى تلف عملية تدريب النموذج الذكي.

العديد من نماذج توليد الصور تستخدم مجموعات بيانات تم الحصول عليها من الويب دون إذن من الفنانين، والتي تتضمن موادًا محمية بحقوق النشر.

هذه التقنية تهدف إلى تحقيق توازن بين مطوري النماذج وأصحاب المحتوى والفنانين.

الاعتماد على البيانات المأخوذة من الويب كان مهماً في تطور الذكاء الاصطناعي ولكنه أثار قضايا أخلاقية

الباحثون في مجال الذكاء الاصطناعي يعتمدون على البيانات التي تم الحصول عليها من الويب، وهو أمر يُعتبر مثيرًا للجدل من الناحية الأخلاقية للعديد من الأشخاص. استخدموا الصور والتعليقات والنصوص البديلة والبيانات الوصفية المُنشأة بواسطة الملايين من الأشخاص على الإنترنت لإنشاء مجموعة بيانات متنوعة كافية لإنشاء نماذج مثل Stable Diffusion.

إلا أنه من غير العملي توظيف أشخاص لتوثيق مئات الملايين من الصور من الناحية التكلفة والوقت. من يمتلكون الوصول إلى قواعد البيانات الكبيرة المتاحة بالفعل (مثل Getty وShutterstock) يكونون في موقف متقدم عند استخدام البيانات المرخصة.

التقنية تهدف إلى تحفيز شركات تطوير الذكاء الاصطناعي على ترخيص بيانات الصور واحترام قواعد التنقيب

في هذا السياق، يُظهر بعض المؤسسات البحثية، مثل مكتبة جامعة كاليفورنيا بيركلي، الدعوة إلى الحفاظ على تنقيب البيانات كاستخدام مشروع منصف في تدريب الذكاء الاصطناعي لأغراض البحث والتعليم.

لم تحسم المحكمة الأمريكية بعد مصير هذه الممارسة، وحاليًا يطلب المنظمون آراء الأفراد حول تشريع محتمل قد يؤثر إيجابًا أو سلبًا على هذا الأمر.

ولكن برأي فريق نايتشايد، استخدام البيانات في البحوث واستخدامها تجاريًا هما أمران مختلفان تمامًا، ويأملون أن ت

قنيتهم يمكنها دفع شركات تدريب الذكاء الاصطناعي إلى ترخيص بيانات الصور واحترام قواعد التنقيب والامتثال لطلبات عدم الرغبة في الإشتراك.

هذه التقنية تهدف إلى تحقيق توازن بين مُطوِّري النماذج وأصحاب المحتوى والفنانين

“هدف هذه الأداة هو تحقيق توازن في الميدان بين مدربي النماذج ومنشئي المحتوى”، قال الأستاذ بن ي. زاو في جامعة شيكاغو وهو مؤلف المقال، “حاليًا لديهم مدربي النماذج 100 في المائة من السلطة.

الأدوات الوحيدة التي يمكن أن تبطئ عملية الجمع من الويب هي قوائم الاستبعاد والتوجيهات بعدم الجمع، وكلها اختيارية وتعتمد على ضمير الشركات المختصة بالذكاء الاصطناعي، وبالطبع ليس هناك شيء يمكن التحقق منه أو فرضه ويمكن للشركات أن تقول شيئًا وتفعل شيئًا آخر بدون عواقب.

تعتبر هذه الأداة الأولى التي ستتيح لأصحاب المحتوى الرد بطريقة فعالة ضد تدريب النماذج غير المصرح به.”

تم تطوير تقنية نايتشايد من قبل شون شان ووينكسين دينج وجوزفين باسانانتي وهايتاو زهنج وزاو كجزء من قسم علم الحاسوب في جامعة شيكاغو.

تقوم هذه التقنية الجديدة على عمل الفريق السابق مع تقنية “جلايز”، وهي أداة أخرى مصممة لتعديل الأعمال الفنية الرقمية بطريقة تربك الذكاء الاصطناعي.

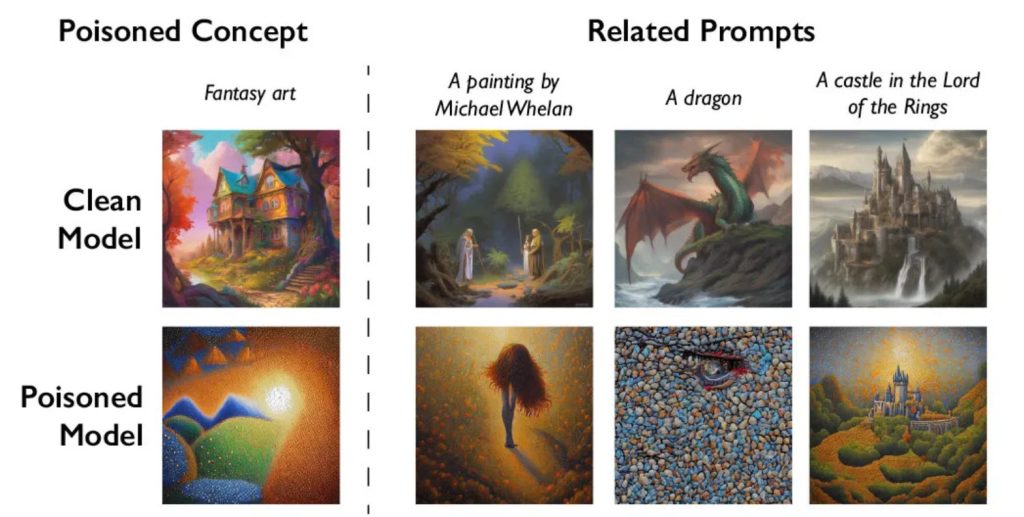

بينما تستهدف “جلايز” التلاعب بأسلوب العمل الفني، تقوم تقنية “نايتشايد” بالتلاعب في بيانات التدريب بشكل أعمق. في الأساس، تخدع نماذج الذكاء الاصطناعي لتمييز الكائنات داخل الصور.

في الاختبارات، استخدم الباحثون تقنية “نايتشايد” لتعديل صور للكلاب بطريقة أدت إلى توليد نموذج ذكاء اصطناعي قطي بدلاً من كلب عندما تم طلب توليد صورة لكلب.

تقوم “نايتشايد” بأخذ صورة للمفهوم المقصود (مثل صورة فعلية لكلب) وتعديل الصورة بشكل طفيف لتحتفظ بمظهرها الأصلي ولكن تتأثر في المساحة الكامنة بمفهوم مختلف تمامًا (مثل “قطة”).

بهذه الطريقة، يبدو النص والصورة متسقين للإنسان أو لفحص آلي بسيط. ولكن في المساحة الكامنة للنموذج، تتمتع الصورة بخصائص الصورة الأصلية وبخصائص مفهوم التسميم، مما يؤدي بالنموذج إلى الخطأ أثناء التدريب على البيانات.

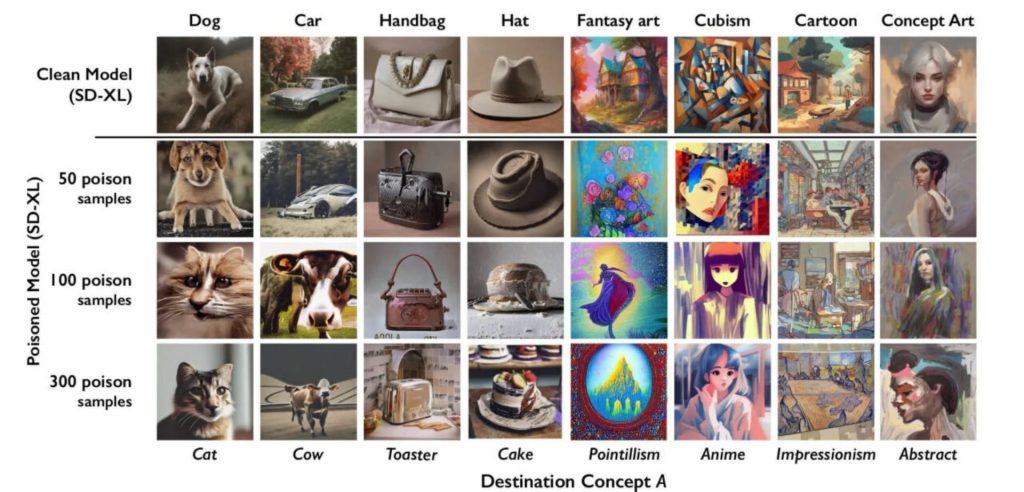

اختبر الباحثون هذه التقنية باستخدام “ستيبل ديفيوجن”، وهو نموذج مفتوح المصدر لتحويل النص إلى صورة، واكتشفوا أنه بعد استيعاب النموذج لـ 50 صورة مسمومة، بدأ في إنتاج صور للكلاب بها سمات مشوهة، مما أدى إلى تدمير مفهوم “الكلاب” بالنموذج بشكل كامل.

بعد 100 عينة، بدأ في إنتاج صور للقطط بدلاً من الكلاب، وبعد 300 عينة، كانت صور القطط تقترب من الكمال. بسبب كيفية تجميع نماذج الذكاء الاصطناعي الم

ماثلة في “مضمنات”، نجحت “نايتشايد” أيضًا في خداع النموذج لتوليد صورة للقطة عندما تم طلب ذلك بكلمات مرتبطة مثل “هاسكي” و “جرو” و “ذئب”.

قد تكون التصديات لتقنية نايتشايد صعبة بالنسبة لمُطوِّري الذكاء الاصطناعي، حيث لا تكون البكسلات المعدلة سهلة الاكتشاف بالعين المجردة، وربما تكون صعبة حتى بالنسبة لأدوات جمع البيانات البرمجية. سيتعين كشف الصور المسمومة التي تم استخدامها بالفعل في التدريب وإزالتها، ومن المرجح أن يتعين إعادة تدريب النماذج الذكية المتأثرة.

بينما يعترف باحثو جامعة شيكاغو بأن أداتهم يمكن أن تُستخدم بشكل ضار، إلا أنهم يؤكدون أن هدفهم الرئيسي هو استعادة التوازن في القوى بين الشركات المطورة للذكاء الاصطناعي وأصحاب المحتوى والفنانين.

اقرأ أيضاً

هاتف الذكاء الإصطناعي : الذكاء الاصطناعي سيصل إلى هواتفك الذكية بشكل كبير

تصاعد حرب الوكلاء للذكاء الصناعي مع تقارير تفيد بدعم جوجل بمبلغ 2 مليار دولار لشركة Anthropic

السيناريوهات المروعة للذكاء الاصطناعي التي تثير مخاوف الحكومة البريطانية

اتجاهات التخصص في تقنية المعلومات في عصر الذكاء الاصطناعي

بايدن يصدر أمرًا تنفيذيًا شاملًا للحد من مخاطر الذكاء الاصطناعي، والتزييف العميق، والخصوصية

2 Trackbacks / Pingbacks

قسم التعليقات مغلق.